La Inteligencia Artificial puede crear imágenes cada vez más reales, moviendo la delgada línea roja entre contenido de calidad y robo de identidad. Cuáles son los problemas que se pueden generar.

La Inteligencia Artificial (IA) está revolucionando muchas industrias, desde la automatización de tareas complejas hasta la generación de contenido creativo. Sin embargo, uno de sus usos más controvertidos es la creación de deepfakes, videos o imágenes hiperrealistas generados mediante algoritmos que pueden manipular la identidad y las acciones de una persona. Este avance plantea una serie de retos éticos, sociales y legales que la sociedad aún está aprendiendo a abordar.

Qué son los deepfakes y cómo se generan

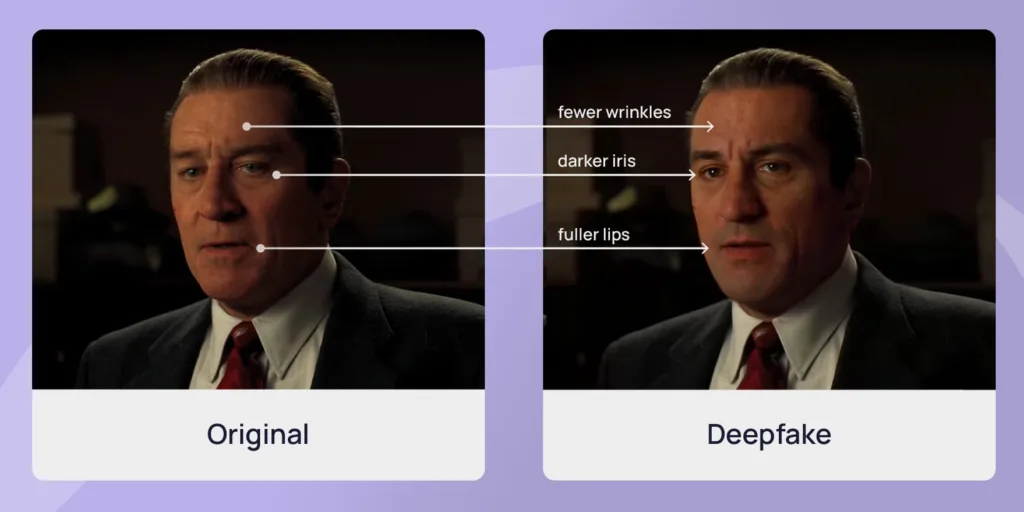

Los deepfakes son un producto de técnicas de inteligencia artificial, en particular, redes generativas antagónicas (GANs). Estas redes enfrentan dos sistemas: uno genera contenido falso y, el otro, evalúa su autenticidad.

Con el tiempo, el modelo mejora hasta producir resultados extremadamente realistas. Aplicando este principio, los deepfakes pueden sustituir el rostro de una persona por otro en un video o incluso imitar su voz de manera casi indistinguible de la real.

- Te puede interesar: Elecciones 2024: advierten que la inteligencia artificial generó un tsunami de información falsa en diversos países

Inicialmente, este avance tuvo aplicaciones positivas, como en la industria del cine y la televisión, permitiendo recrear actores fallecidos o rejuvenecer personajes. Sin embargo, también abrió la puerta a usos malintencionados.

La suplantación de identidades a través de deepfakes

Uno de los problemas más graves asociados a los deepfakes es su capacidad para suplantar identidades. Los ciberdelincuentes utilizan esta tecnología para crear videos falsos de figuras públicas o personas comunes, con fines que van desde la difamación hasta el fraude.

Los criminales desarrollan videos falsos de carácter íntimo para amenazar a personas, exigiendo dinero o favores a cambio de no difundir el contenido. También se han hecho deepfakes de voz que permiten a los estafadores hacerse pasar por ejecutivos de alto nivel, ordenando transferencias de grandes sumas de dinero.

Inclusive, los políticos han sido víctimas de deepfakes que los muestran diciendo o haciendo cosas que nunca ocurrieron, lo que exacerba las tensiones sociales y políticas.

A muchas celebridades, como Taylor Swift, también se les ha cuestionado su reputación por contenido sexual que ni siquiera era suyo, sino una imagen creada con Inteligencia Artificial. De hecho, los cibercriminales muchas veces utilizan la imagen de los famosos para crear contenido en Only Fans o sitios online de citas.

Deepfakes en la creación de contenido

A pesar de los riesgos arraigados a la ciberdelincuencia, los deepfakes también irrumpen en el robo de identidad al estar transformando la manera en que se produce contenido creativo. Muchas productoras de cine y videojuegos utilizan esta tecnología para generar personajes digitales hiperrealistas o recrear actuaciones de actores icónicos.

Las marcas también están experimentando con deepfakes para personalizar campañas publicitarias, creando anuncios en los que los personajes hablan directamente al consumidor en su idioma o incluso mencionando su nombre. En los entornos educativos, a su vez, pueden recrear figuras históricas que “hablan” con los estudiantes, haciendo el aprendizaje más interactivo.

Pero también resulta en un impacto negativo para quienes trabajan en el rubro de creación de contenido en redes. Muchos influencers están recibiendo muchas menos vistas en sus publicaciones porque los deepfakes creados con Inteligencia Artificial que utilizan su imagen se las están llevando hacia ellos. Estas cuentas con identidades robadas entraron en la competencia de las redes.

Si bien algunas aplicaciones pueden ser positivas, se necesita una regulación adecuada para evitar su mal uso.

Los riesgos de la desinformación masiva

Los deepfakes son un arma poderosa en la era de la información. Al ser tan convincentes, tienen el potencial de engañar a millones de personas. Por ejemplo, el uso de imágenes hechas con IA en propagandas de gobiernos o grupos de interés podría influir en la opinión pública difundiendo noticias falsas.

Los videos falsos también pueden exacerbar conflictos étnicos, religiosos o políticos al presentar “evidencia” manipulada de eventos que nunca ocurrieron. Esto podría provocar que la gente empiece a dudar de cualquier contenido visual o auditivo, incluso el genuino.

Herramientas para combatir los deepfakes

La misma tecnología que permite la creación de deepfakes también puede ayudar a combatirlos. Varias empresas y organizaciones están desarrollando herramientas basadas en IA para detectar contenido manipulado. Estas soluciones analizan patrones en los archivos que indican manipulación digital, como inconsistencias en la iluminación, el parpadeo de los ojos o la calidad del audio.

Por ejemplo, existe Microsoft Video Authenticator el cual está diseñado para identificar deepfakes en tiempo real, calculando un puntaje de probabilidad de manipulación. Por otro lado, también están las aplicaciones que autentican imágenes y videos al momento de su captura, garantizando que no han sido alterados posteriormente.

Además, plataformas como Facebook, YouTube y Twitter han implementado políticas para identificar y eliminar contenido manipulado, aunque los avances rápidos de esta tecnología dificultan mantenerse al día.

Qué se está haciendo a nivel legal en el mundo

La regulación de los deepfakes es todavía incipiente, pero algunos países han comenzado a tomar medidas. En Estados Unidos, algunas zonas, como California, han prohibido su uso con fines políticos en períodos electorales o para la difusión de contenido explícito no consensuado.

- Te puede interesar: ¿Qué son los Deepfakes y cuál es el rol de la Inteligencia Artificial en todo esto?

En Europa, la Ley de Servicios Digitales incluye provisiones para que las plataformas identifiquen y marquen contenido manipulado. Pero China, por su lado, ha implementado estrictas normativas que exigen a las empresas indicar claramente si un video ha sido generado mediante IA.

A pesar de estos avances, el desafío radica en equilibrar la protección de los derechos individuales con la libertad de expresión y la innovación tecnológica.